|

先来几个名词解释: hadoop:apache基金会的开源分布式计算平台。 MapReduce :hadoop的分布式计算模型,由map任务和reduce任务组成。 Jobtracker :hadoop计算系统的总控。 Tasktracker :hadoop计算系统的子节点。 Slot(槽位) :tasktracker的最小计算分配单元,一个槽位可以对应一个map任务, 一个机器启动一个tasktracker,槽位的话按照机器的cpu核数来分配,一般是”核数-1”。

1. 什么是Hadoop资源感知调度器? Hadoop资源感知调度器是指调度器根据各个TaskTracker当前资源负载情况(cpu,内存,网络io等)动态决定将新任务调度给哪个节点处理。 2. Hadoop资源感知调度器的必要性和重要性 当前绝大多数Hadoop调度器是按照slot多少进行调度。在Hadoop中,存在两种slot:map slot和reduce slot,每个节点可以根据自己实际的CPU个数配置slot个数,一次配好后,启动Hadoop便不可修改。 一旦某个节点上出现空闲的slot,调度器便会分配一个task给该节点。Slot类似于令牌,map task需要拿到一个map slot才可运行,类似,reduce task需要拿到一个reduce slot才可运行,如果当前所有slot都被task占用了,则剩下的task需要排队。 了解当前调度器的基本原理后,便会发现当前调度器存在很大缺陷。调度器的基本作用是:为需要计算机资源的任务分配资源,使他们能够顺利完成计算任务。这里的计算机资源包括cpu,内存,网络,磁盘等,而当前所有调度器几乎只考虑了cpu资源,这就导致TaskTracker经常出现OOM或者网络阻塞等现象,严重时,可能会把机器搞挂! 3. 如何设计资源感知调度器? Hadoop调度器模型实际上是一个典型的任务指派模型,即:资源量是M,任务数是N,如果将这M个资源分配给这N个任务,使他们尽可能利用所有资源,尽快完成任务。

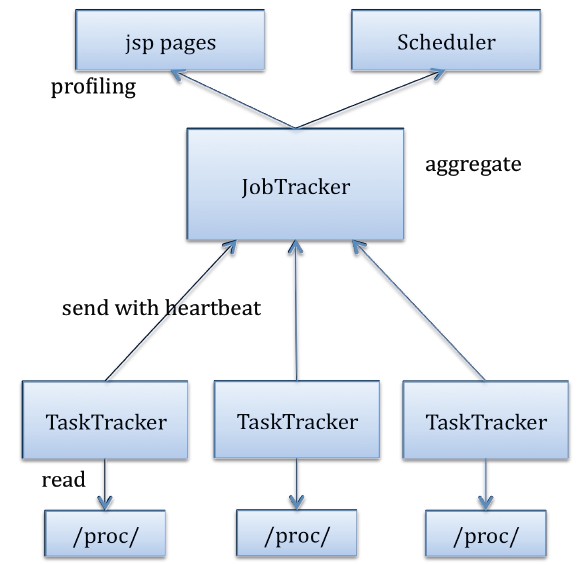

为了实现该模型,一个Hadoop资源感知调度器需要包括四个模块: (1) 信息采集模块 各个TaskTracker周期性的采集本节点上的资源信息,这些信息主要由两部分组成:机器总体资源和每个task资源使信息,这里的资源信息包括cpu使用情况,内存使用情况,网络和磁盘情况等。为了减少获取资源的代价,可以从linux 虚拟文件系统/proc目录下获取; (2) 信息传输模块 TaskTracker采集的资源信息通过heartbeat发送给JobTracker,默认情况下,heartbeat发送周期是3s。完了完成该模块,需要稍微修改一下Hearbeat包; (3) 信息聚集模块 JobTracker收集到信息后,会进行聚集,如:以job为单位做统计等; (4) 作业调度模块 调度器从JobTracker上获取各个节点资源使用情况,并以此制定调度策略。 4. 资源感知调度器难度在哪? Hadoop感知调度器最大难度在于调度,这实际上一个多目标决策问题,理论上没有最优解,一般需要设计启发式算法。 5. 资源感知调度器方面的资料 (1)https://issues.apache.org/jira/browse/MAPREDUCE-220 (2)论文:Towards a Resource Aware Scheduler in Hadoop ,http://www-personal.umich.edu/~shiwali/images/hadoop.pdf (3)Multiple-Job Optimization in MapReduce for Heterogeneous Workloads Weisong Hu; Chao Tian; Xiaowei Liu; Hongwei Qi; Li Zha; Huaming Liao; Yuezhuo Zhang; Jie Zhang; Semantics Knowledge and Grid (SKG), 2010 Sixth International Conference on 6. 说明 Hadoop自带的Capacity Scheduler能够调度大内存任务,原理是:默认情况下每个slot对应一个内存量,当用户提交作业时,需配置一个task需要的内存量,然后两个值相除取丄整便得到了一个task对应的slot数。如:你提交了一个作业,告诉调度器一个task要使用4GB内存,而默认情况下一个slot对应2GB内存,则没运行一个你的task,会使用2个slot。 Q: 对hadoop而言,什么样的作业是属于memory-intensive的,所谓的内存需求很大的作业,这样的作业对fair scheduler又会有什么样不同的要求? 像wordcount,sort是属于memory-intensive的作业吗?

memory-intensive或者CPU-intensive也是相对而言的,通常,对于那些使用内存资源明显多于CPU资源的,可称为memory-intensive。对于大资源需求的作业,Hadoop不能够很好的解决的,Hadoop采用了基于槽位的调度框架,也就是说,每个节点上配有一定数目的槽位,每个task只能使用一个槽位,这隐含着,所有槽位是一样的,代表的资源是一样的,比如你的一个节点上有10G可用内存,你配置了10个槽位,这意味着每个task使用1G内存,如果一个task使用了5G,则很可能把这个节点撑爆。 Hadoop面前也在改进这个调度框架,主要是支持一个task可使用多个槽位,现在的Capacity Scheduler支持该功能,其他调度器,比如fair,不支持!你说的wordcount和sort是中性的作业,使用的cpu和内存差不多,而Hadoop example里面的解数独谜题和PI作业是典型的CPU类型。 (责任编辑:IT) |