某国内大型游戏开发商有超过130个IDC部署MySQL实例,存储总量达20T。因业务需要,将全部实例迁移到腾讯云CDB for MySQL。腾讯云数据库团队为保证业务迁移顺利进行,对迁移流程,工具进行了前期的调查研究,并对过程中发现的4大问题进行及时解决,以下是实际迁移经验分享: 一. 测试用例/过程目前开发商上云(外部MySQL迁移到CDB)提供多种方案,其中开发商的MySQL实例有外网IP的可以直接使用腾讯云数据库迁移工具完成迁移(其他的迁移方法参见链接本次迁移任务中该开发商的所有MySQL实例均有外网代理IP供使用,故直接选用迁移工具完成数据导入。 迁移工具的基本原理:通过待迁移实例提供的高权限帐号获取源实例基本的MySQL实例配置,并同步到目标CDB实例;通过mysqldump直接将源实例导出传输到CDB实例后导入;源数据库实例和目标CDB建立主从关系同步新数据。其中CDB实例与源IDC之间通过NAT方式以一台带外网的服务器为中转发起通信。 1. 迁移工具基本功能在腾讯云数据库控制台页面根据引导建立迁移任务;在后台管理页面观察迁移任务后台日志等。

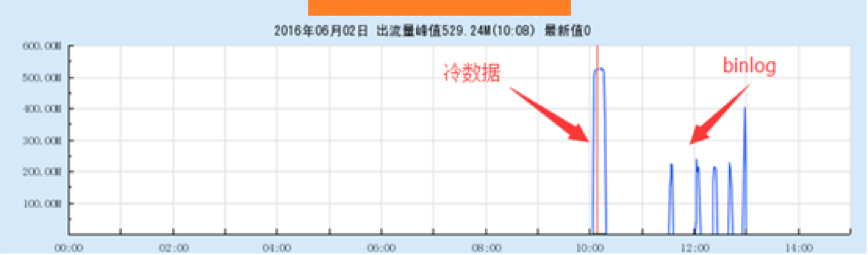

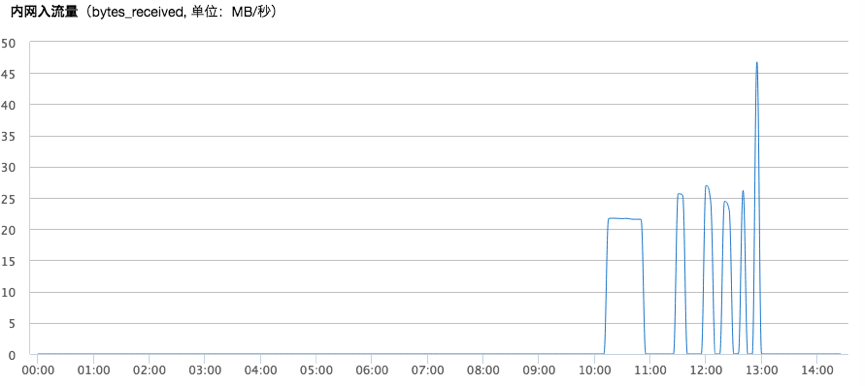

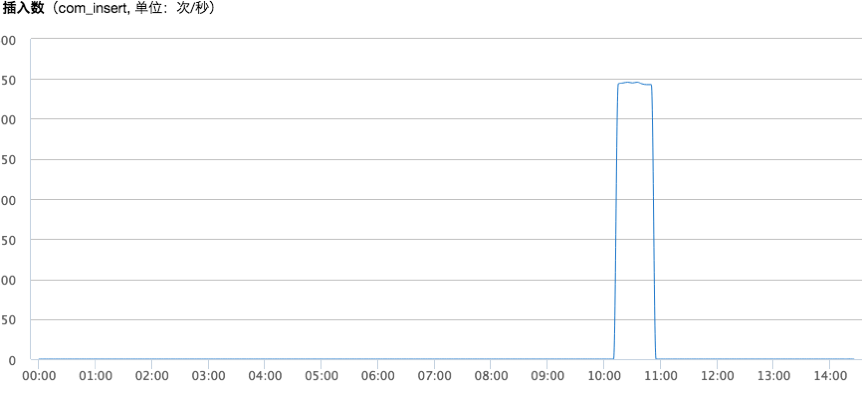

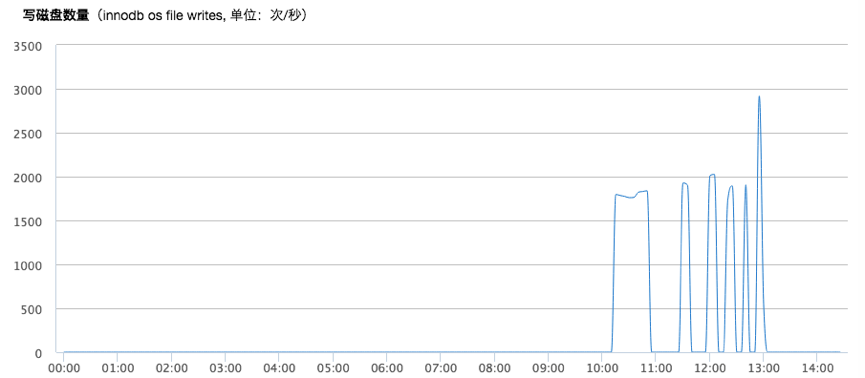

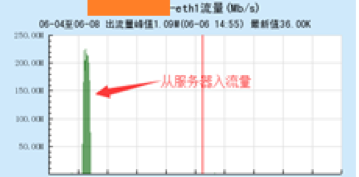

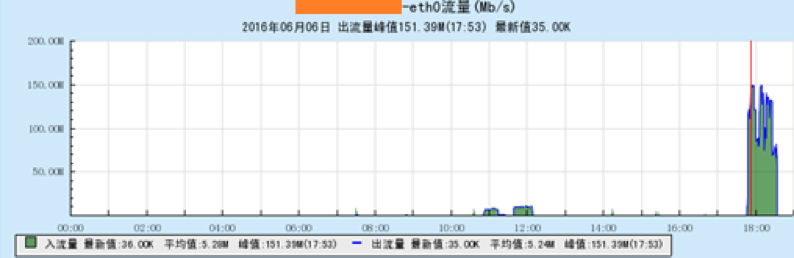

任务开始运行后检测代理机器流量变化,CDB的写入等数据展示

知识点:如何为测试数据库产生较大的数据量。这里推荐一个工具mysql_gen_data。产生测试数据并导入到MySQL的过程如下:

#!/bin/bash

./mysql_gen_data -f "%1n,%100s,%100s,%100s,%100s,%100s" \

-n 10000000 >random.dat

mysql –uroot –p*********** –e “create database cdbtest;use cdbtest; \

CREATE TABLE cdbtest_tb \

(c1 varchar(100),c2 varchar(100),c3 varchar(100), \

c4 varchar(100),c5 varchar(100),c6 varchar(100)) \

ENGINE=InnoDB DEFAULT CHARSET=utf8;”

for i in {1..10}; do

echo "$(date '+%T') round $i start"

echo "prepare data..."

sed -i "s/^/$i/" random.dat

echo "insert data..."

mysql -uroot –p******** cdbtest -e "LOAD DATA local INFILE '/data/random.dat' into table cdbtest_tb fields terminated by',';"

echo "$(date '+%T') round $i end"

done

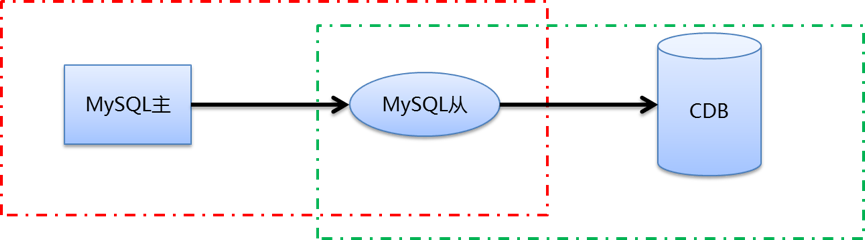

2. 主从以及从机和CDB建立主从的同步

由于本次迁移的开发商将使用他们自建IDC的从机向CDB迁移数据,简单关系如下图,之前没有使用迁移工具进行过类似操作,故进行本次测试。 server_id = 98 log_bin = binlog binlog_format = ROW innodb_stats_on_metadata = off

3. 多实例+较大binlog并发同步

开发商在经过相关测试后,一期计划15个实例并发迁移到CDB,每天总共产生约100G的binlog。由于之前迁移工具没有大并发使用,且单日有较大数据更新,故提前测试用户场景。测试的基本架构如下图:在一个服务器上开启15个MySQL实例映射到不同端口,15个MySQL实例同时和15个CDB实例建立主从,并发起迁移任务。 [mysqld_multi] mysqld = /usr/bin/mysqld_safe mysqladmin = /usr/bin/mysqladmin user = root password = ****** [mysqld1] port = 3306 datadir=/var/lib/mysql socket=/var/lib/mysql/mysql.sock pid-file=/var/lib/mysqld.pid server_id = 11 log_bin = binlog binlog_format = ROW expire_logs_days=1 innodb_stats_on_metadata = off symbolic-links=0 user = root sql_mode=NO_ENGINE_SUBSTITUTION,STRICT_TRANS_TABLES [mysqld2] port = 3312 datadir=/data/mysql12 socket=/data/mysql12/mysql.sock pid-file=/data/mysql12/mysqld.pid server_id = 12 log_bin = binlog binlog_format = ROW expire_logs_days=1 innodb_stats_on_metadata = off user = root symbolic-links=0 sql_mode=NO_ENGINE_SUBSTITUTION,STRICT_TRANS_TABLES [mysqld3] ........ [mysqld4] .......

然后使用mysqld_multi start 1-4启动配置项里面的对应数量实例即可。启动多个MySQL实例如图:

#!/bin/sh

SET_STRING=`date +"%s"`

LOG_NAME="/data/log/update.log"

NOW_STRING=`date +"[%Y-%m-%d %H:%M:%S]"`

for i in {12..26}

do

BEGIN_TIME=`date +"[%Y-%m-%d %H:%M:%S]"`

echo ${BEGIN_TIME}" Update data in this time is:"$SET_STRING >> $LOG_NAME

echo ${BEGIN_TIME}" Update database"${i} "start..." >> $LOG_NAME

mysql -uroot migrate${i} -S /data/mysql${i}/mysql.sock -e "update tb set data1="${SET_STRING}""

END_TIME=`date +"[%Y-%m-%d %H:%M:%S]"`

echo ${END_TIME}" Update database"${i} "end..." >> $LOG_NAME

done

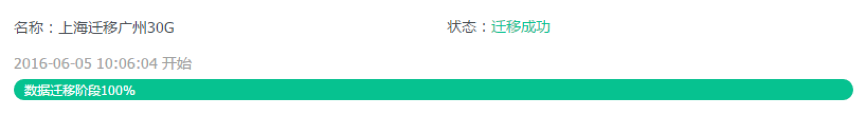

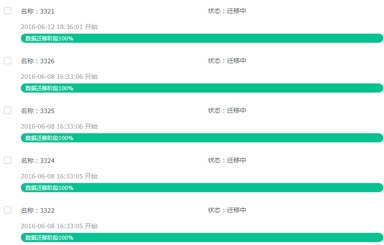

使用数据库迁移工具建立15个迁移任务,控制台和后台检查均迁移成功:

#!/bin/sh

DATA_CORRECT=$1

NOW_TIME=`date +"[%Y-%m-%d %H:%M:%S]"`

cat my.file | while read line

do

IP=`echo $line | awk -F " " '{print $1}'`

PORT=`echo $line | awk -F " " '{print $2}'`

DATABASE=`echo $line | awk -F " " '{print $3}'`

DATA_INBASE=`mysql -uroot -P${PORT} -h${IP} -p123456cdb ${DATABASE} -e "select data1 from tb limit 1\G" | grep data1 | awk -F " " '{print $2}'`

echo ${NOW_TIME}"[INFO]Data you want to update to ${DATABASE} is:"$DATA_CORRECT

echo ${NOW_TIME}"[INFO]Data from Database "$DATABASE" is:"$DATA_INBASE

if [ $DATA_INBASE -eq $DATA_CORRECT ]

then

echo ${NOW_TIME}"[SUCCESS]"$DATABASE" update succesfully!"

else

echo ${NOW_TIME}"[ERROR]"$DATABASE" update ERROR!"

fi

done

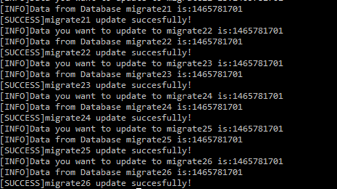

通过校验日志可以看到,数据更新均成功完成。 二. 开发商迁移测试数据记录

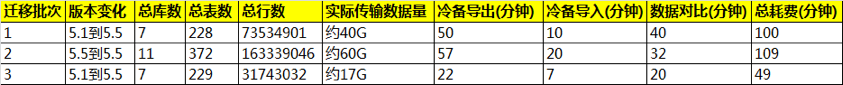

以上我方内部测试完成后,开发商自行进行了3次迁移,相关数据如下:

某次迁移的带宽表现。 三.遇到的问题

四. 总结凡事预则立不预则废。正是因为客户在迁移前我们有多项功能测试,性能测试和边界条件测试的预备,使得在正式数据迁移时未出现数据不一致、现网运营切换故障等任何异常情况。为现网大规模的数据库实例迁移积累了经验。截止目前,客户逾130个MySQL实例已顺利迁移到腾讯云CDB并开启现网运营。基于这样的经验,我们有能力也有信心为腾讯云用户提供更加优质高效的数据存储迁移服务。 (责任编辑:IT) |