CentOS安装Scala和Spark

时间:2016-12-14 01:54 来源:blog.csdn.net 作者:IT

一.安装Scala

Scala程序运行在java虚拟机(JVM)上,所以安装Scala之前需要先在linux系统中安装Java。由于之前已经安装了,没安装的可以到我的文章http://blog.csdn.net/xqclll/article/details/53466713去查看。

到Scala的官网上去下载相应操作系统的scala版本,解压到安装路径下,然后修改文件权限,使hadoop用户拥有对scala目录的权限。

-

1

配置环境变量:

-

1

-

1

-

2

使环境变量生效:

-

1

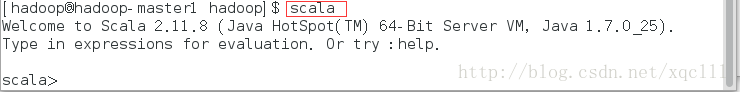

检验一下是否设置正确,可以输入scala命令:

-

1

结果:

二. 安装Spark 安装Spark之前要装好hadoop, 到Spark官网上去下载Spark,要选hadoop2.6的: spark-2.0.2-bin-hadoop2.6 Spark可以安装单机的,也可以安装分布式的,由于之前已经配置了hadoop的集群,所以这里的Spark也配置成分布 式的。

具体步骤: 1.解压Spark,并且设置hadoop用户的使用权限

-

1

-

2

2.配置环境变量:

-

1

-

1

-

2

-

1

3.修改配置文件 修改spark-env.sh conf文件下的spark-env.sh.template拷贝为spark-env.sh

-

1

-

2

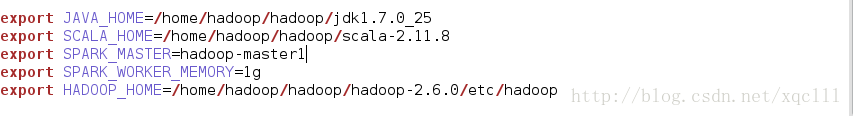

在该文件中添加java,Scala,hadoop,spark的环境变量

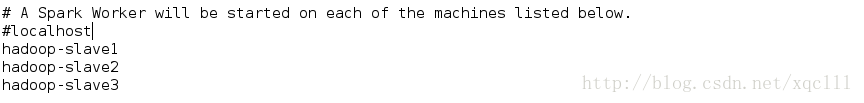

修改slaves

-

1

把配置好的scala整个文件传到其他三台slave主机:

-

1

-

2

-

3

把配置好的spark整个文件传到其他三台slave主机:

-

1

-

2

-

3

然后配置其他几台slave主机上的scala和spark环境变量。

开始测试Spark 进入到spark的sbin下面,使用如下命令启动spark,启动之前要先启动hadoop。

-

1

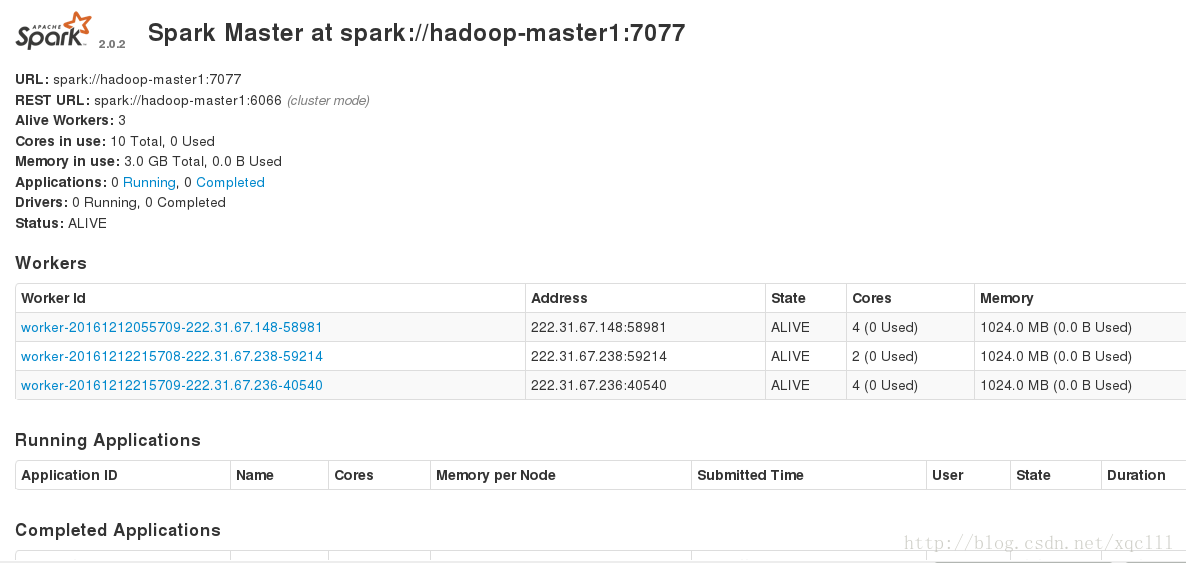

如果除hadoop的其他进程之外在hadoop-master1上面出现了Master进程,hadoop-slave1,hadoop-slave2,hadoop-slave3上出现了Worker进程。那么可以说明Spark安装配置成功。

还可以到web页面下去看: hadoop-master1:8080

(责任编辑:IT)

一.安装Scala Scala程序运行在java虚拟机(JVM)上,所以安装Scala之前需要先在linux系统中安装Java。由于之前已经安装了,没安装的可以到我的文章http://blog.csdn.net/xqclll/article/details/53466713去查看。 到Scala的官网上去下载相应操作系统的scala版本,解压到安装路径下,然后修改文件权限,使hadoop用户拥有对scala目录的权限。

配置环境变量:

使环境变量生效:

检验一下是否设置正确,可以输入scala命令:

结果:

二. 安装Spark 安装Spark之前要装好hadoop, 到Spark官网上去下载Spark,要选hadoop2.6的: spark-2.0.2-bin-hadoop2.6 Spark可以安装单机的,也可以安装分布式的,由于之前已经配置了hadoop的集群,所以这里的Spark也配置成分布 式的。 具体步骤: 1.解压Spark,并且设置hadoop用户的使用权限

2.配置环境变量:

3.修改配置文件 修改spark-env.sh conf文件下的spark-env.sh.template拷贝为spark-env.sh

在该文件中添加java,Scala,hadoop,spark的环境变量 修改slaves

把配置好的scala整个文件传到其他三台slave主机:

把配置好的spark整个文件传到其他三台slave主机:

然后配置其他几台slave主机上的scala和spark环境变量。 开始测试Spark 进入到spark的sbin下面,使用如下命令启动spark,启动之前要先启动hadoop。

如果除hadoop的其他进程之外在hadoop-master1上面出现了Master进程,hadoop-slave1,hadoop-slave2,hadoop-slave3上出现了Worker进程。那么可以说明Spark安装配置成功。

还可以到web页面下去看: hadoop-master1:8080 (责任编辑:IT) |