|

2 月 18 日,DeepSeek 官方发文公布了一篇新的论文,论文提出了一种新的注意力机制「NSA」。 据 DeepSeek 介绍,「原生稀疏注意力 (Native Sparse Attention, NSA) 」是一个用于超快长上下文训练和推断的本地可训练的稀疏注意力机制,并且还具有与硬件对齐的特点。

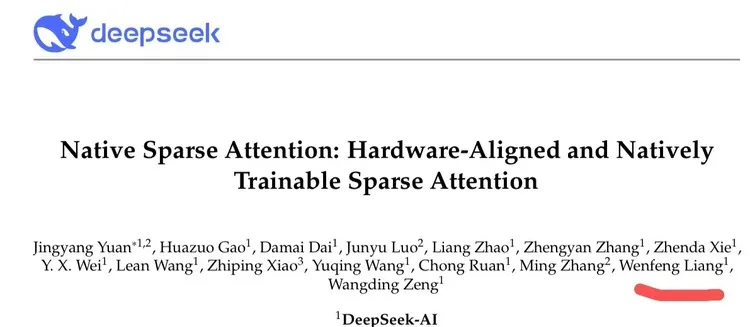

NSA 核心组件包括:

研究通过对现实世界语言语料库的综合实验来评估 NSA。其中作者评估了 NSA 在通用语言评估、长上下文评估和链式推理评估中的表现。实验结果表明,NSA 实现了与 Full Attention 基线相当或更优的性能,同时优于现有的稀疏注意力方法。 此外,与 Full Attention 相比,NSA 在解码、前向和后向阶段提供了明显的加速,且加速比随着序列长度的增加而增加。这些结果验证了分层稀疏注意力设计有效地平衡了模型能力和计算效率。 另外,有网友发现,arXiv 上 NSA 这篇论文的提交记录显示,它于 2 月 16 日提交,提交者正是梁文锋本人,他也是这篇论文的合著者。

|