|

安装以及配置Java

#chmod 777 jre-6u31-linux-x64-rpm.bin

#./jre-6u31-linux-x64-rpm.bin

#vim /etc/profile

#最后添加

# set java environment

export JAVA_HOME=/usr/java/jre1.6.0_31

export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

生效java变量:

#source /etc/profile

# java -version

在所有的机器上都建立相同的目录,也可以就建立相同的用户,最好是以该用户的home路径来做hadoop的安装路径。安装路径都是:/home/hadoop/hadoop-1.2.1

#useradd hadoop

#passwd hadoop #密码也为hadoop

# su - hadoop

$ ssh-keygen -t rsa

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ chmod 0600 ~/.ssh/authorized_keys

#su - hadoop #wget http://apache.stu.edu.tw/hadoop/common/hadoop-1.2.1/hadoop-1.2.1.tar.gz #tar -zxvf hadoop-1.2.1.tar.gz

我的安装目录为: /home/hadoop/hadoop-1.2.1 为了方便,使用hadoop命令或者start-all.sh等命令,修改节点上/etc/profile 新增以下内容: export HADOOP_HOME=/home/hadoop/hadoop-1.2.1 export PATH=$PATH:$HADOOP_HOME/bin 修改完毕后,执行source /etc/profile 来使其生效。

配置conf/hadoop-env.sh文件,添加: export JAVA_HOME=/usr/java/jre1.6.0_31 这里修改为你的jdk的安装位置。

cd $HADOOP_HOME/bin

/home/hadoop/hadoop-1.2.1/bin/hadoop jar ./hadoop-1.2.1/hadoop-examples-1.2.1.jar wordcount ./hadoop-1.2.1/conf/ /tmp/out

vi /home/hadoop/hadoop-1.2.1/conf/core-site.xml

<configuration>

<property>

</configuration>

vi /home/hadoop/hadoop-1.2.1/conf/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

vi /home/hadoop/hadoop-1.2.1/conf/mapred-site.xml

<property>

<name>mapred.job.tracker</name>

<value>localhost:8021</value>

</property>

</configuration>

start-mapred.sh

stop-dfs.sh

stop-mapred.sh

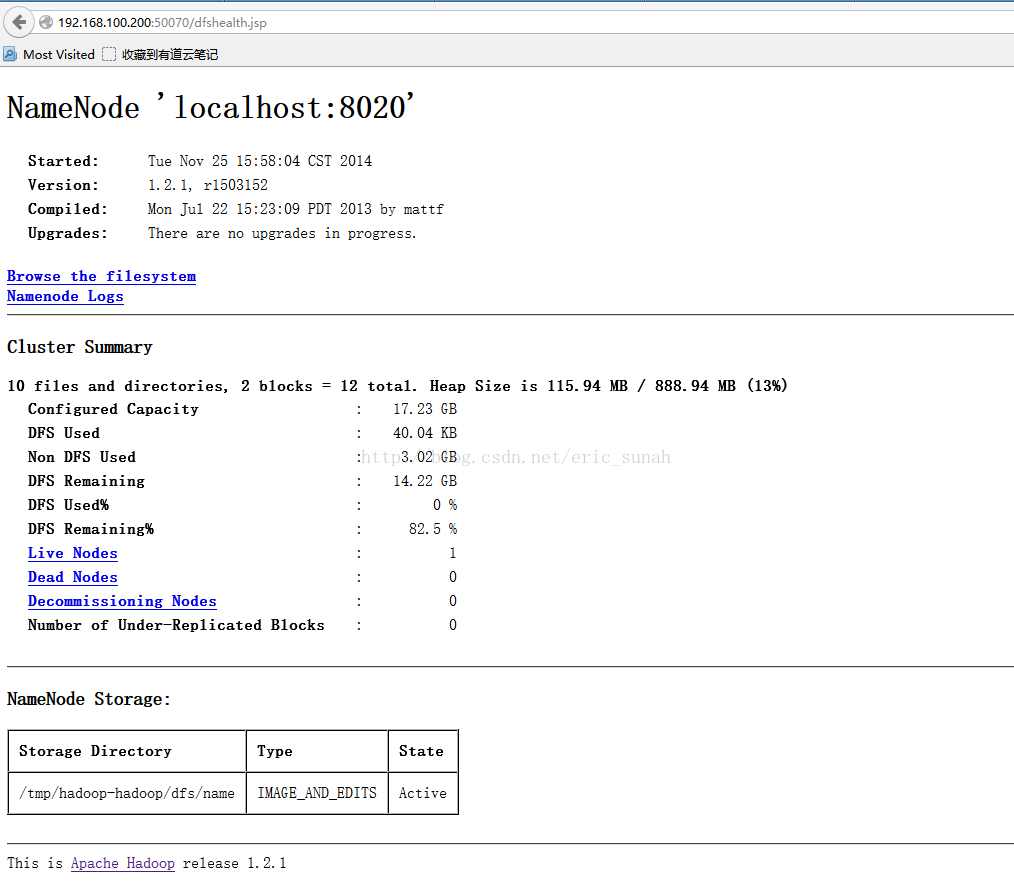

Hadoop NameNode 默认端口是50070

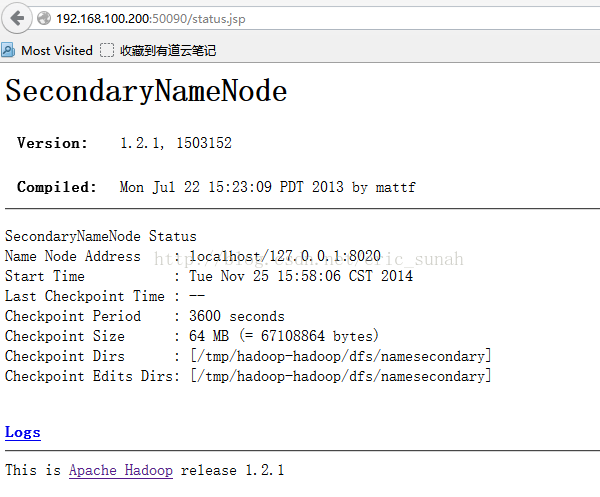

访问port 50090 得到 secondary namenode的相关信息.

访问port 50075 得到 DataNode的相关信息. (责任编辑:IT) |