1/首先在官网下载hadoop文件,hadoop-0.23.6.tar.gz

2/系统下要安装jdk

我的系统jdk安装在:JAVA_HOME=/usr/lib/jvm/java-6-oracle

3/解压hadoop-0.23.6.tar.gz文件:

|

1

|

tar -xvzf hadoop-0.23.6.tar.gz

|

给文件设置所有者

|

1

|

#chown -R tianbx:tianbx title.txt

|

4/编辑 conf/hadoop-env.sh文件,至少需要将JAVA_HOME设置为Java安装根路径。

5/创建一个纸箱hadoop的安装目录的环境变量,将二进制目录放到命令行路径上。

|

1

2

|

export HADOOP_INSTALL=/home/hadoop/

export PATH=$PATH:$HADOOP_INSTALL/bin

|

这样就可以不用加hadoop路径了,直接使用hadoop命令:

|

1

2

3

4

|

hadoop versionHadoop 0.20.2

Subversion https://svn.apache.org/repos/asf/hadoop/common/branches/branch-0.20 -r 911707

Compiled by chrisdo on Fri Feb 19 08:07:34 UTC 2010

root@tianbaoxing-virtual-machine:/home/hadoop/java#

|

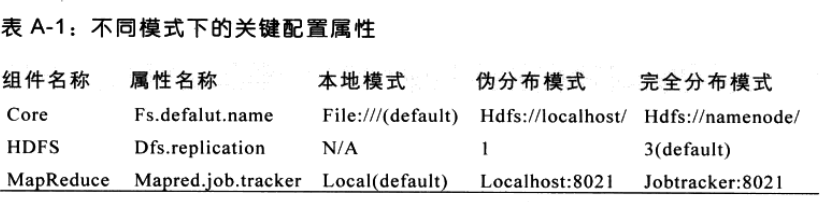

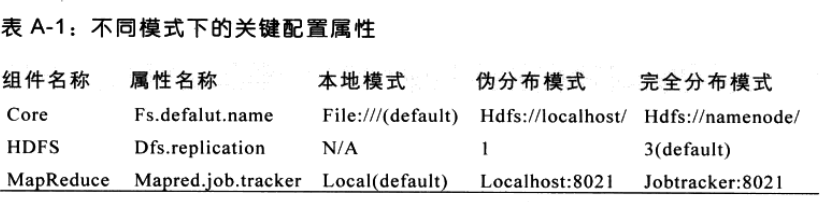

6/hadoop中的每一个组件都是用一个xml文件配置。核心属性在core-site.xml中,HDFS属性在hdfs-site.xml中,MapReduce属性在mapred-site.xml.这些文件都在conf子目录下。

在一个特定的模式下运行hadoop时,需要注意:(1)设置适当的属性,并启动hadoop的守护进程。

7/修改conf/core-site.xml,改为:

|

1

2

3

4

5

6

7

8

9

10

11

12

|

viewplaincopytoclipboardprint?

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/data/hadoop</value>

<description>A base for other temporary directories.</description>

</property>

</configuration>

|

8/修改conf/hdfs-site.xml,改为:

|

1

2

3

4

5

6

7

|

viewplaincopytoclipboardprint?

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

|

9/修改conf/mapred-site.xml,改为:

|

1

2

3

4

5

6

7

|

viewplaincopytoclipboardprint?

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

|

默认情况下,Hadoop被配置成以非分布式模式运行的一个独立Java进程。这对调试非常有帮助。

10/设置本机ssh本机无密码

先测试一下,输入命令sshlocalhost,如果提示密码,则需要进行以下操作:

$ssh-keygen-tdsa-P''-f~/.ssh/id_dsa

$cat~/.ssh/id_dsa.pub>>~/.ssh/authorized_keys

11/格式化namenode:

$bin/hadoopnamenode-format

12/启动Hadoop:

$bin/start-all.sh

13/关闭hadoop

$bin/hadoop/stop-all.sh

进入hadoop主目录的bin目录下

$cd hadoop/bin

$./hadoop namenode -format //格式化hadoop namenode,很多时候namenode启动不起来可以试试格式化一下,会好使。

$./start-all.sh //启动hadoop的各个监护进程

可以通过http://localhost:50070 和http://localhost:50030 查看namenode和jobtracker。

$./stop-all.sh //关闭hadoop的各个监护进程

可以参考:http://www.michael-noll.com/tutorials/running-hadoop-on-ubuntu-linux-single-node-cluster/

(责任编辑:IT) |