|

基于Eclipse的Hadoop应用开发环境配置

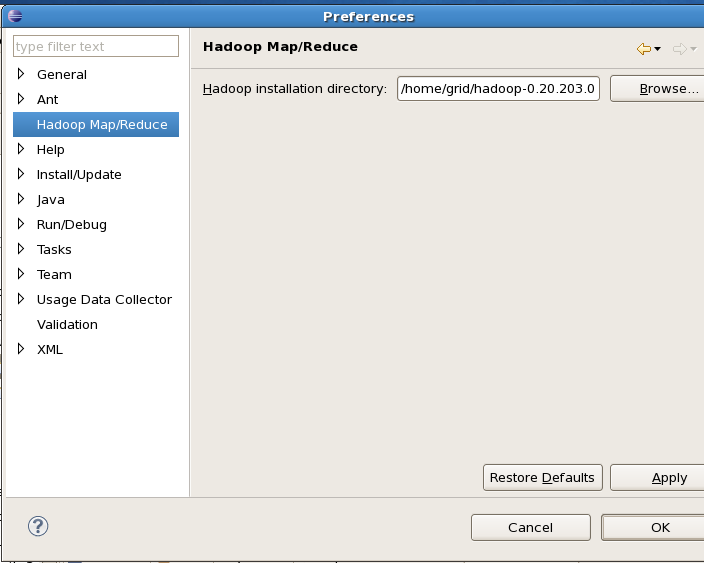

我的开发环境: 操作系统centos5.5 一个namenode 两个datanode Hadoop版本:hadoop-0.20.203.0 Eclipse版本:eclipse-java-helios-SR2-linux-gtk.tar.gz(使用3.7的版本总是崩溃,让人郁闷) 第一步:先启动hadoop守护进程 具体参看:http://www.cnblogs.com/flyoung2008/archive/2011/11/29/2268302.html 第二步:在eclipse上安装hadoop插件

1.复制 hadoop安装目录/contrib/eclipse-plugin/hadoop-0.20.203.0-eclipse-plugin.jar 到 eclipse安装目录/plugins/ 下。

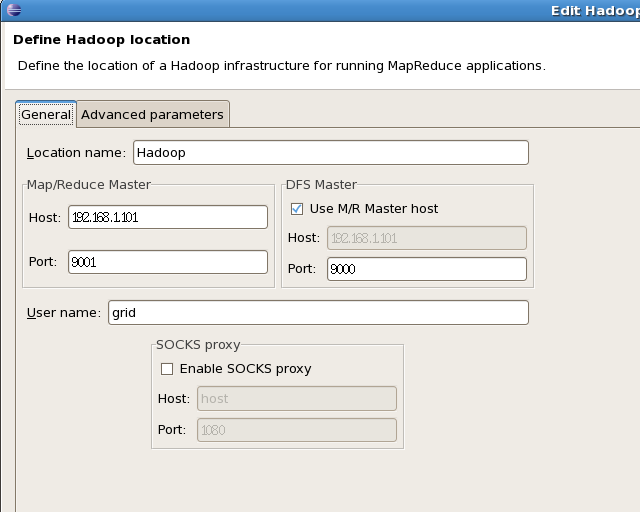

3.配置Map/Reduce Locations。 Map/Reduce Master 192.168.1.101 9001 DFS Master 192.168.1.101 9000

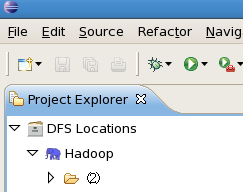

配置完后退出。点击DFS Locations-->Hadoop如果能显示文件夹(2)说明配置正确,如果显示"拒绝连接",请检查你的配置。

java c++ python c java c++ javascript helloworld hadoop mapreduce java hadoop hbase 通过hadoop的命令在HDFS上创建/tmp/workcount目录,命令如下:bin/hadoop fs -mkdir /tmp/wordcount 通过copyFromLocal命令把本地的word.txt复制到HDFS上,命令如下:bin/hadoop fs -copyFromLocal /home/grid/word.txt /tmp/wordcount/word.txt

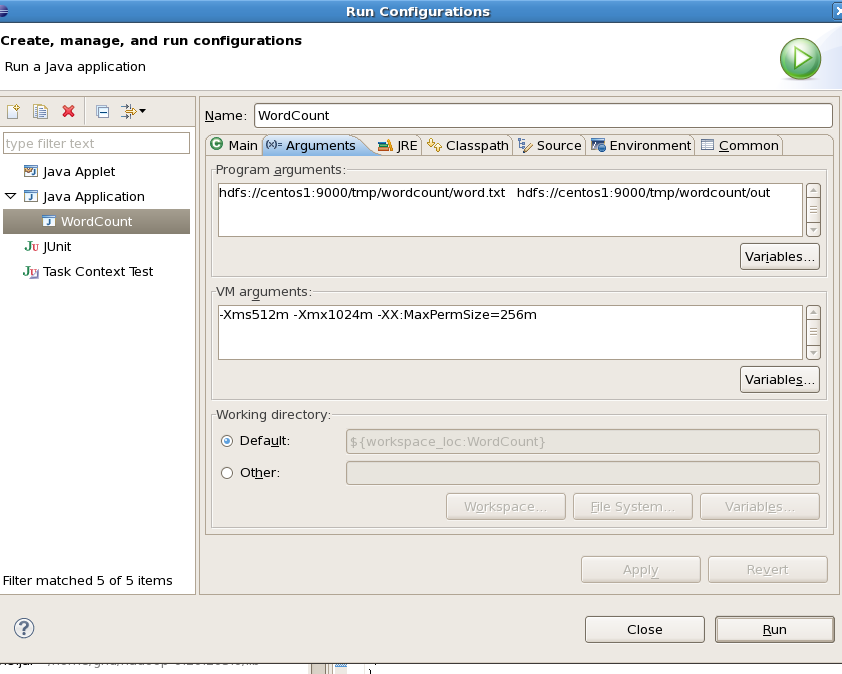

1.在新建的项目Hadoop,点击WordCount.java,右键-->Run As-->Run Configurations hdfs://centos1:9000/tmp/wordcount/word.txt hdfs://centos1:9000/tmp/wordcount/out 4、如果运行时报java.lang.OutOfMemoryError: Java heap space 配置VM arguments(在Program arguments下) -Xms512m -Xmx1024m -XX:MaxPermSize=256m

5.点击Run,运行程序。 c 1 c++ 2 hadoop 2 hbase 1 helloworld 1 java 3 javascript 1 mapreduce 1 python 1 (责任编辑:IT) |