|

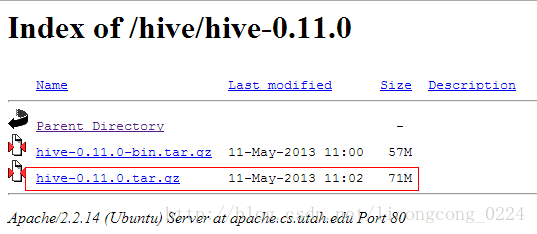

1 、下载Hive-0.11.0 http://apache.cs.utah.edu/hive/hive-0.11.0/

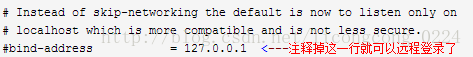

2、解压安装 Hive原则上可以安装在集群上的任何一台机器上面,但是考虑到 master节点的负荷比较大,我们选择一台机器性能较好的datanode来安装hive。在我们的集群中选择cloud003来安装hive。另外,在我们的安装中采用MySQL来存放hive的meta数据。 2.1 解压 将hive-0.11.0.tar.gz解压到/home/hduser路径下 tar –zxvf hive-0.11.0.tar.gz 产生hive 的安装目录:/home/hduser/hive-0.11.0 如果所有配置都采用默认情况,此时hive已经可用。这里有一个问题需要注意的是,Hadoop的安装路径要添加到/etc/profile,否则 hive运行时将找不到hadoop。(此时可跳过第2.2步骤,测试hive是否正常运行) 2.2配置 mySQL存放metadata (可选) 1) 这里默认mySQL已经安装(root/mysql)。由于 mysql的默认安装只允许本地登录,所以需要修改配置文件将地址绑定注释掉:

2)重启mysql: sudoservice mysql restart 3)登录msql,创建database: hive 4)修改hive配置文件hive-site.xml 默认这个文件是不存在的,进入hive安装路径(/home/hduser/hive-0.11.0/)在conf目录下,拷贝hive-default.xml.template得到hive-site.xml文件 修改以下属性: <configuration> <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://16.187.94.183:3306/hive?characterEncoding=UTF-8</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>root</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>mysql</value> </property> </configuration>

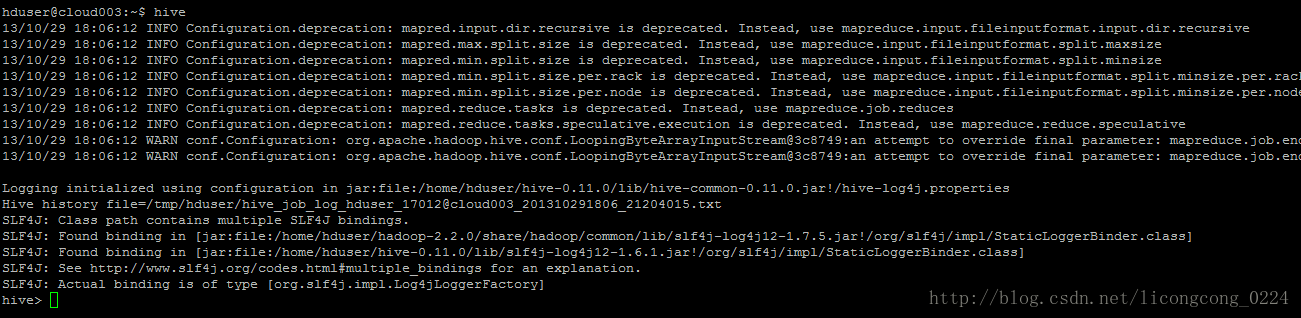

5)把mySQL的JDBC驱动包复制到Hive的lib目录下 这里下载的版本是:mysql-connector-Java-5.0.8-bin.jar 3、启动运行 3.1 配置环境变量 vim /etc/profile 添加hive环境变量: export HIVE_HOME=/home/hduser/hive-0.11.0 export PATH=$HIVE_HOME/bin:$PATH source /etc/profile 3.2 启动hive 在终端直接输入:hive即可,如下图:

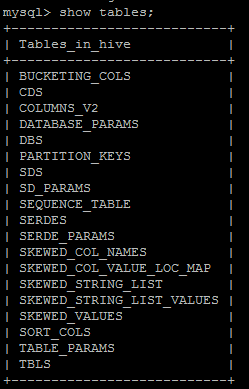

3.3 验证hive 1)在hive上建立数据表 Hive>create table test(id int,name string) row formatdelimited fields terminated by ’\t’; 2)登录mySQL查看meta信息 use hive; show tables;(如下图)

select* from TBLS; 至此hive配置安装成功! (责任编辑:IT) |