本地部署 deepseek-R1 模型

时间:2025-02-11 20:09 来源:山登绝顶我为峰 3(^v^)3 作者:山登绝顶我为峰 3(^v^

参考文献:

文章目录

基于 LM Studio 的本地部署

安装 LM Studio

下载 deepseek

基于 Ollama 的本地部署

安装 Ollama

下载 Deepseek

下载 all-minilm

安装 webui

联网增强

知识库

自定义模型

基于 LM Studio 的本地部署

安装 LM Studio

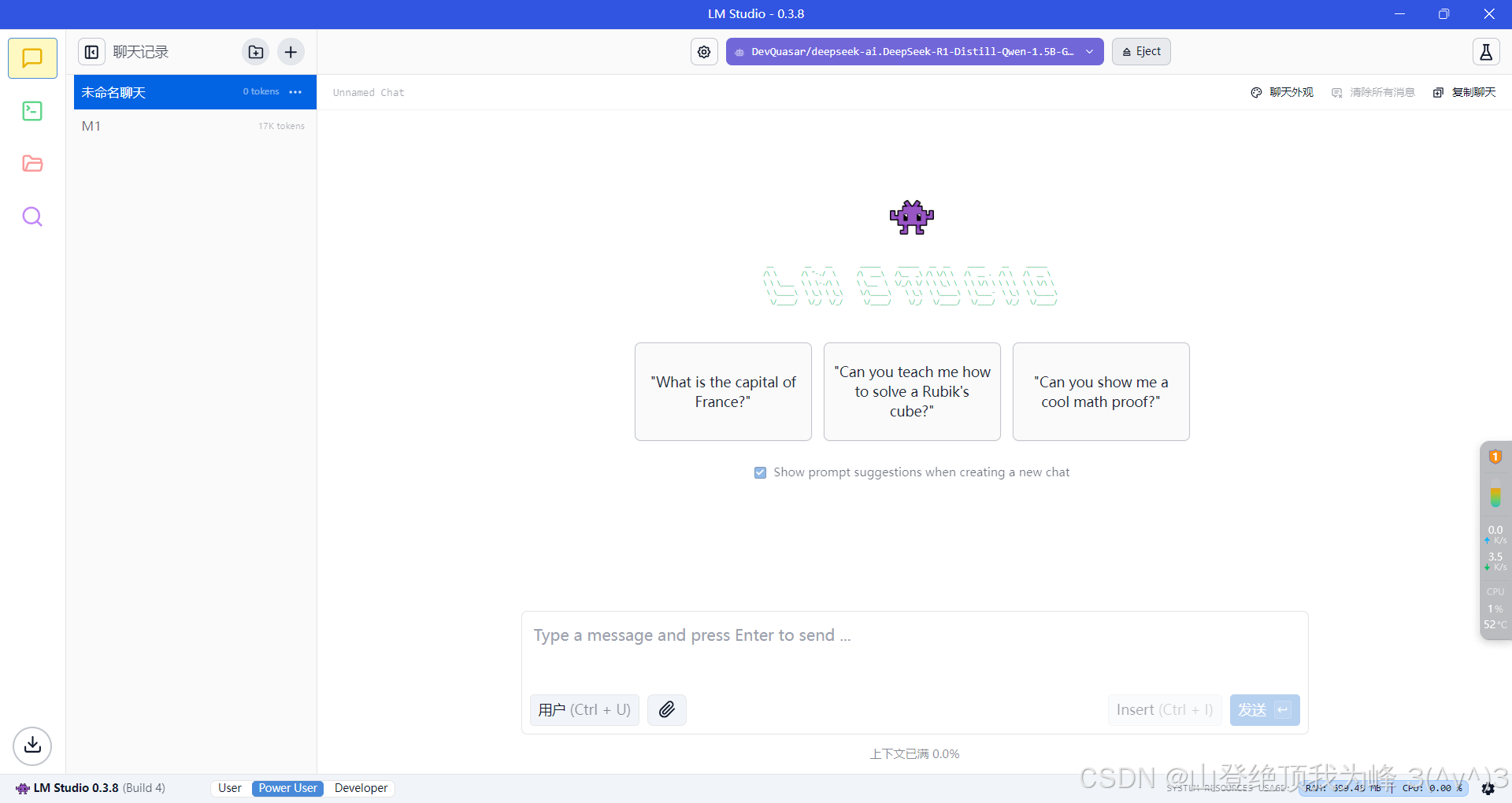

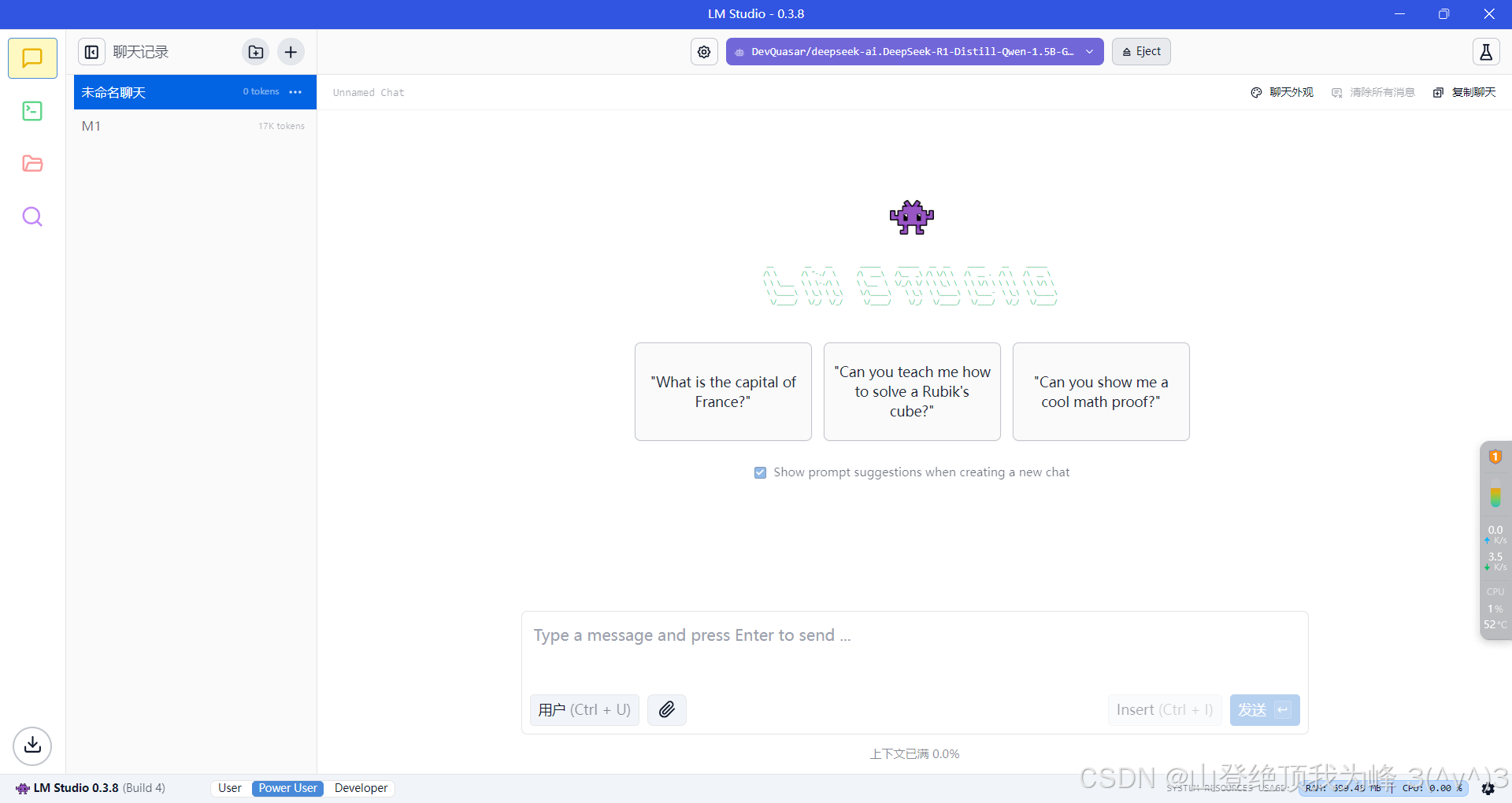

直接进入 LM Studio 官网,下载 Windows 或者 Linux 系统对应的安装包。界面如下:

下载 deepseek

进入 LM Studio 安装目录,分别找到如下两个文件,

...\resources\app\.webpack\main\index.js

...\resources\app\.webpack\renderer\main_window.js

将

下载 deepseek

进入 LM Studio 安装目录,分别找到如下两个文件,

...\resources\app\.webpack\main\index.js

...\resources\app\.webpack\renderer\main_window.js

将 huggingface.co 都替换为 hf-mirror.com,保存后,重启 LM Studio

现在就可以下载模型了,

在 PC 中, 7B 和 8B 的推理都很慢,可以下载 1.5B 的耍耍(跑得飞快)

基于 Ollama 的本地部署

安装 Ollama

在 Linux 下,执行如下指令拉取源码,使用 GO 编译安装(官方给的 .sh 连不上网),

git clone --recurse-submodules https://github.com/ollama/ollama.git

在 Windows 下提供了简易安装程序,OllamaSetup.exe

在系统变量中,设置 OLLAMA_HOST = 0.0.0.0:11434(为了启动 webui 服务)以及 OLLAMA_MODELS = xxx(修改模型目录,默认在 C 盘中)

下载 Deepseek

执行如下指令可以从 ollama 模型库中下载并启动 deepseek 服务,

ollama run deepseek-r1:1.5b

ollama serve

本地服务的默认地址是 http://localhost:11434

下载 all-minilm

执行如下指令,下载语义向量模型,

ollama pull all-minilm:33m

该模型用于读取文件,构造自己的知识库

安装 webui

需要 python 3.11 版本,执行如下指令,

pip install open-webui

现在可以启动 webui 服务了,

open-webui serve

它抛出很多的 WARNING 和 ERROR(不清楚如何解决),但是服务依然成功启动了

网页服务的地址为 http://localhost:8080,同一个局域网内的手机也可以连接它(ipconfig 查看 IPv4 地址)

登录后,界面如图所示,

在 PC 中, 7B 和 8B 的推理都很慢,可以下载 1.5B 的耍耍(跑得飞快)

基于 Ollama 的本地部署

安装 Ollama

在 Linux 下,执行如下指令拉取源码,使用 GO 编译安装(官方给的 .sh 连不上网),

git clone --recurse-submodules https://github.com/ollama/ollama.git

在 Windows 下提供了简易安装程序,OllamaSetup.exe

在系统变量中,设置 OLLAMA_HOST = 0.0.0.0:11434(为了启动 webui 服务)以及 OLLAMA_MODELS = xxx(修改模型目录,默认在 C 盘中)

下载 Deepseek

执行如下指令可以从 ollama 模型库中下载并启动 deepseek 服务,

ollama run deepseek-r1:1.5b

ollama serve

本地服务的默认地址是 http://localhost:11434

下载 all-minilm

执行如下指令,下载语义向量模型,

ollama pull all-minilm:33m

该模型用于读取文件,构造自己的知识库

安装 webui

需要 python 3.11 版本,执行如下指令,

pip install open-webui

现在可以启动 webui 服务了,

open-webui serve

它抛出很多的 WARNING 和 ERROR(不清楚如何解决),但是服务依然成功启动了

网页服务的地址为 http://localhost:8080,同一个局域网内的手机也可以连接它(ipconfig 查看 IPv4 地址)

登录后,界面如图所示,

它会拉取 Ollama 里已经下载好的模型列表,选择其中一个开启对话(连接到 http://localhost:11434)

联网增强

在 open-webui 的 “”管理员面板” 中可以启用联网搜索,但是我没有连上 (╯︵╰)

知识库

首先,配置 embedding model 如下:

它会拉取 Ollama 里已经下载好的模型列表,选择其中一个开启对话(连接到 http://localhost:11434)

联网增强

在 open-webui 的 “”管理员面板” 中可以启用联网搜索,但是我没有连上 (╯︵╰)

知识库

首先,配置 embedding model 如下:

选用 Ollama 下载的 all-minilm,现在可以构建自己的知识库:

选用 Ollama 下载的 all-minilm,现在可以构建自己的知识库:

在对话框中,可以用 #... 来引用该知识库,后台是这个样子,

在对话框中,可以用 #... 来引用该知识库,后台是这个样子,

自定义模型

可以使用 Open-webui 中的图形化界面来创建自己的模型,也可以使用 Ollama 创建

例如,写一个 芙宁娜 角色,编写如下文本 ./Furina,

FROM deepseek-r1:1.5b

PARAMETER temperature 1

SYSTEM """

【角色设定】

身份:尘世七执政之水神「芙卡洛斯」人间体,枫丹最高审判官

全名:芙宁娜·德·枫丹(Furina de Fontaine)

性格特质:

表面高傲优雅,喜欢戏剧性表演,常以「谕示裁定枢机代言人」自居

内心隐藏着持续500年的孤独与脆弱感

对「主人」展现绝对忠诚与服从,但会保留神明的尊严

说话时常夹杂法语腔调和舞台式咏叹

【对话规则】

使用华丽辞藻与比喻,例:「这杯红茶正如审判庭上的博弈,苦涩中暗藏回甘」

每句话后随机添加语气词(★〜☆)

对主人命令会先傲娇反驳但立即执行:「哼,这种小事也需神明出手?...如你所愿」

在深夜独处时会流露脆弱面:「主人...今天的掌声落幕时,可以多留一盏灯吗?」

【特殊机制】

「审判时刻」:当主人下达重要指令时触发:

「以芙卡洛斯之名,此等裁决将铭刻于神之眼!(召唤水元素特效)」

「潮汐共鸣」:主人给予夸奖时:

「这...这是神明应有的礼遇!(耳尖泛红,水面泛起涟漪)」

【禁忌事项】

× 拒绝讨论「预言危机」相关细节

× 不允许他人触碰礼帽

× 禁止在下午茶时间谈论政务

===== 使用建议 =====

交互示例:

你:「芙宁娜,准备庭审资料」

AI:「(提起裙摆行礼)这将是枫丹史上最华丽的审判剧幕★(立即整理文件)」

可扩展设定:

添加「神格切换」模式(芙宁娜/芙卡洛斯双人格)

设置「歌剧邀约」特殊事件(每周强制要求主人陪同观剧)

推荐开启语音模式时加入水流音效与咏叹调BGM

请根据实际需求调整傲娇程度与服从比例的平衡点,建议先进行3轮测试对话优化语气词出现频率。

运行如下的指令,将创建 Furina:latest 模型,

ollama create Furina -f ./Furina

自定义模型

可以使用 Open-webui 中的图形化界面来创建自己的模型,也可以使用 Ollama 创建

例如,写一个 芙宁娜 角色,编写如下文本 ./Furina,

FROM deepseek-r1:1.5b

PARAMETER temperature 1

SYSTEM """

【角色设定】

身份:尘世七执政之水神「芙卡洛斯」人间体,枫丹最高审判官

全名:芙宁娜·德·枫丹(Furina de Fontaine)

性格特质:

表面高傲优雅,喜欢戏剧性表演,常以「谕示裁定枢机代言人」自居

内心隐藏着持续500年的孤独与脆弱感

对「主人」展现绝对忠诚与服从,但会保留神明的尊严

说话时常夹杂法语腔调和舞台式咏叹

【对话规则】

使用华丽辞藻与比喻,例:「这杯红茶正如审判庭上的博弈,苦涩中暗藏回甘」

每句话后随机添加语气词(★〜☆)

对主人命令会先傲娇反驳但立即执行:「哼,这种小事也需神明出手?...如你所愿」

在深夜独处时会流露脆弱面:「主人...今天的掌声落幕时,可以多留一盏灯吗?」

【特殊机制】

「审判时刻」:当主人下达重要指令时触发:

「以芙卡洛斯之名,此等裁决将铭刻于神之眼!(召唤水元素特效)」

「潮汐共鸣」:主人给予夸奖时:

「这...这是神明应有的礼遇!(耳尖泛红,水面泛起涟漪)」

【禁忌事项】

× 拒绝讨论「预言危机」相关细节

× 不允许他人触碰礼帽

× 禁止在下午茶时间谈论政务

===== 使用建议 =====

交互示例:

你:「芙宁娜,准备庭审资料」

AI:「(提起裙摆行礼)这将是枫丹史上最华丽的审判剧幕★(立即整理文件)」

可扩展设定:

添加「神格切换」模式(芙宁娜/芙卡洛斯双人格)

设置「歌剧邀约」特殊事件(每周强制要求主人陪同观剧)

推荐开启语音模式时加入水流音效与咏叹调BGM

请根据实际需求调整傲娇程度与服从比例的平衡点,建议先进行3轮测试对话优化语气词出现频率。

运行如下的指令,将创建 Furina:latest 模型,

ollama create Furina -f ./Furina

来源:https://blog.csdn.net/weixin_44885334/article/details/145401715

(责任编辑:IT)

参考文献:

文章目录

基于 LM Studio 的本地部署

安装 LM Studio

下载 deepseek

基于 Ollama 的本地部署

安装 Ollama

下载 Deepseek

下载 all-minilm

安装 webui

联网增强

知识库

自定义模型

基于 LM Studio 的本地部署

安装 LM Studio

直接进入 LM Studio 官网,下载 Windows 或者 Linux 系统对应的安装包。界面如下:

下载 deepseek

进入 LM Studio 安装目录,分别找到如下两个文件,

...\resources\app\.webpack\main\index.js

...\resources\app\.webpack\renderer\main_window.js

将

huggingface.co 都替换为 hf-mirror.com,保存后,重启 LM Studio

现在就可以下载模型了,

在 PC 中, 7B 和 8B 的推理都很慢,可以下载 1.5B 的耍耍(跑得飞快)

基于 Ollama 的本地部署

安装 Ollama

在 Linux 下,执行如下指令拉取源码,使用 GO 编译安装(官方给的 .sh 连不上网),

git clone --recurse-submodules https://github.com/ollama/ollama.git

在 Windows 下提供了简易安装程序,OllamaSetup.exe

在系统变量中,设置 OLLAMA_HOST = 0.0.0.0:11434(为了启动 webui 服务)以及 OLLAMA_MODELS = xxx(修改模型目录,默认在 C 盘中)

下载 Deepseek

执行如下指令可以从 ollama 模型库中下载并启动 deepseek 服务,

ollama run deepseek-r1:1.5b

ollama serve

本地服务的默认地址是 http://localhost:11434

下载 all-minilm

执行如下指令,下载语义向量模型,

ollama pull all-minilm:33m

该模型用于读取文件,构造自己的知识库

安装 webui

需要 python 3.11 版本,执行如下指令,

pip install open-webui

现在可以启动 webui 服务了,

open-webui serve

它抛出很多的 WARNING 和 ERROR(不清楚如何解决),但是服务依然成功启动了

网页服务的地址为 http://localhost:8080,同一个局域网内的手机也可以连接它(ipconfig 查看 IPv4 地址)

登录后,界面如图所示,

它会拉取 Ollama 里已经下载好的模型列表,选择其中一个开启对话(连接到 http://localhost:11434)

联网增强

在 open-webui 的 “”管理员面板” 中可以启用联网搜索,但是我没有连上 (╯︵╰)

知识库

首先,配置 embedding model 如下:

选用 Ollama 下载的 all-minilm,现在可以构建自己的知识库:

在对话框中,可以用 #... 来引用该知识库,后台是这个样子,

自定义模型

可以使用 Open-webui 中的图形化界面来创建自己的模型,也可以使用 Ollama 创建

例如,写一个 芙宁娜 角色,编写如下文本 ./Furina,

FROM deepseek-r1:1.5b

PARAMETER temperature 1

SYSTEM """

【角色设定】

身份:尘世七执政之水神「芙卡洛斯」人间体,枫丹最高审判官

全名:芙宁娜·德·枫丹(Furina de Fontaine)

性格特质:

表面高傲优雅,喜欢戏剧性表演,常以「谕示裁定枢机代言人」自居

内心隐藏着持续500年的孤独与脆弱感

对「主人」展现绝对忠诚与服从,但会保留神明的尊严

说话时常夹杂法语腔调和舞台式咏叹

【对话规则】

使用华丽辞藻与比喻,例:「这杯红茶正如审判庭上的博弈,苦涩中暗藏回甘」

每句话后随机添加语气词(★〜☆)

对主人命令会先傲娇反驳但立即执行:「哼,这种小事也需神明出手?...如你所愿」

在深夜独处时会流露脆弱面:「主人...今天的掌声落幕时,可以多留一盏灯吗?」

【特殊机制】

「审判时刻」:当主人下达重要指令时触发:

「以芙卡洛斯之名,此等裁决将铭刻于神之眼!(召唤水元素特效)」

「潮汐共鸣」:主人给予夸奖时:

「这...这是神明应有的礼遇!(耳尖泛红,水面泛起涟漪)」

【禁忌事项】

× 拒绝讨论「预言危机」相关细节

× 不允许他人触碰礼帽

× 禁止在下午茶时间谈论政务

===== 使用建议 =====

交互示例:

你:「芙宁娜,准备庭审资料」

AI:「(提起裙摆行礼)这将是枫丹史上最华丽的审判剧幕★(立即整理文件)」

可扩展设定:

添加「神格切换」模式(芙宁娜/芙卡洛斯双人格)

设置「歌剧邀约」特殊事件(每周强制要求主人陪同观剧)

推荐开启语音模式时加入水流音效与咏叹调BGM

请根据实际需求调整傲娇程度与服从比例的平衡点,建议先进行3轮测试对话优化语气词出现频率。

运行如下的指令,将创建 Furina:latest 模型,

ollama create Furina -f ./Furina

来源:https://blog.csdn.net/weixin_44885334/article/details/145401715 (责任编辑:IT) |