|

安装结束

四、Hadoop启动与测试 1、格式化一个新的分布式文件系统

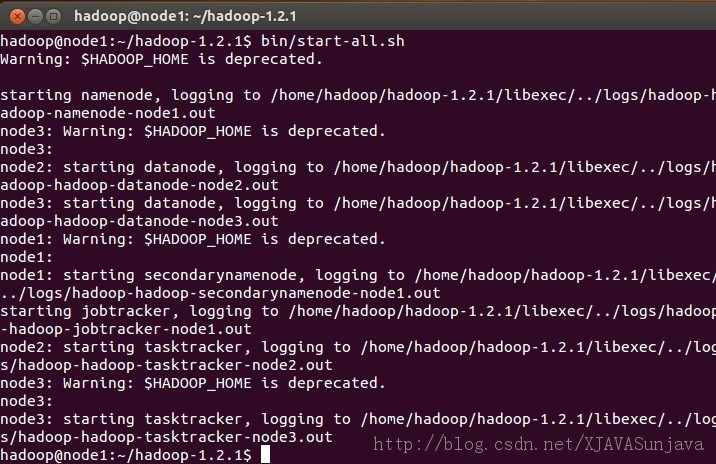

成功的情况下输入一下(我的hadoop已经使用,不想重新格式化选择了No) 2、启动所有节点

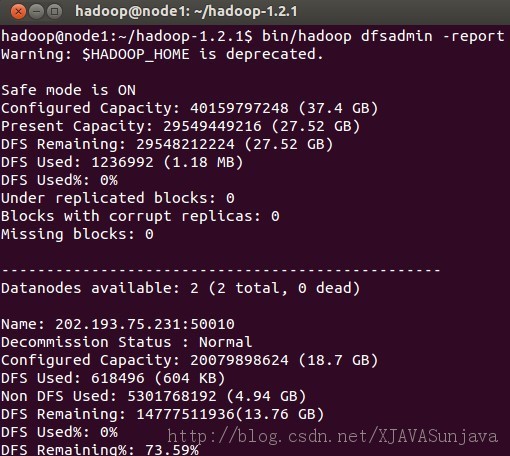

3、查看集群的状态:

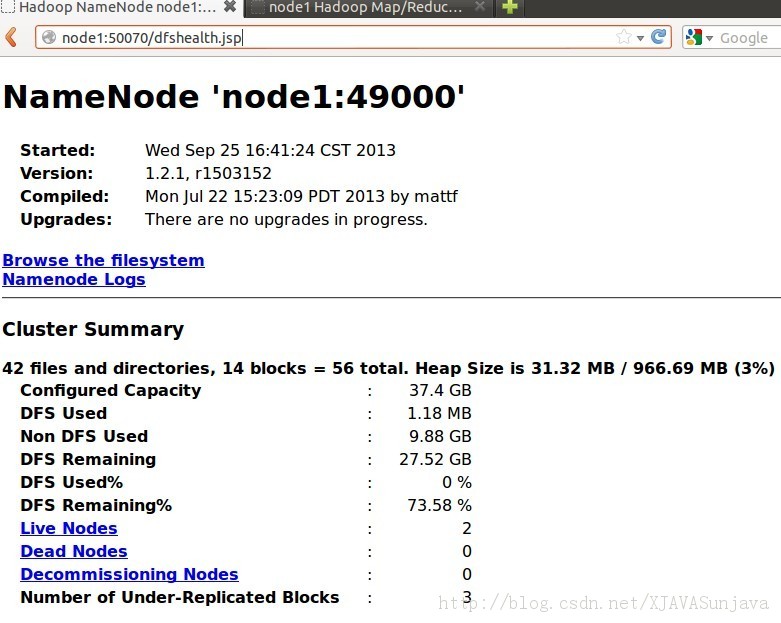

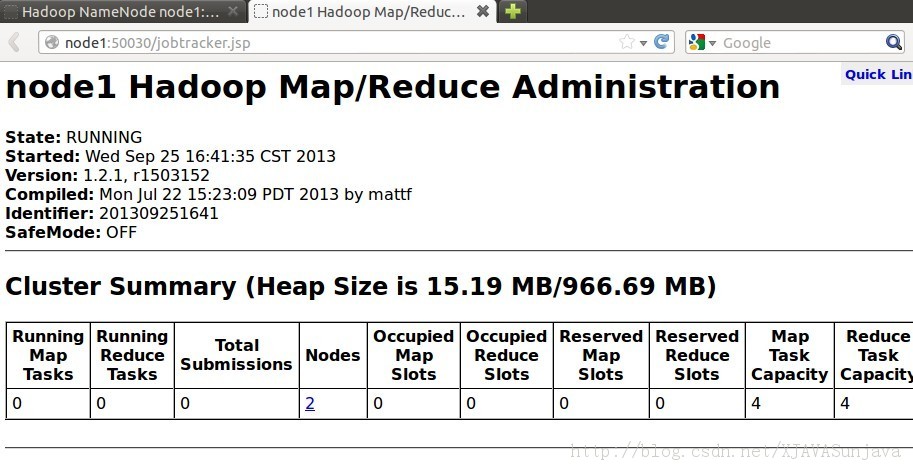

4、Hadoop测试 浏览NameNode和JobTracker的网络接口,它们的地址默认为: NameNode - http://node1:50070/ JobTracker - http://node1:50030/ 要想检查守护进程是否正在运行,可以使用 jps 命令(这是用于 JVM 进程的ps 实用程序)。这个命令列出 5 个守护进程及其进程标识符。 将输入文件拷贝到分布式文件系统:

到此为止,hadoop已经配置完成,当然在配置的过程中会遇到各种错误,主要都是权限问题和网络ip配置问题,请注意。 五、Hadoop一些常用的操作命令 1、hdfs常用操作: hadoopdfs -ls 列出HDFS下的文件 hadoop dfs -ls in 列出HDFS下某个文档中的文件 hadoop dfs -put test1.txt test 上传文件到指定目录并且重新命名,只有所有的DataNode都接收完数据才算成功 hadoop dfs -get in getin 从HDFS获取文件并且重新命名为getin,同put一样可操作文件也可操作目录 hadoop dfs -rmr out 删除指定文件从HDFS上 hadoop dfs -cat in/* 查看HDFS上in目录的内容 hadoop dfsadmin -report 查看HDFS的基本统计信息,结果如下 hadoop dfsadmin -safemode leave 退出安全模式 hadoop dfsadmin -safemode enter 进入安全模式 2、负载均衡 start-balancer.sh,可以使DataNode节点上选择策略重新平衡DataNode上的数据块的分布。 (责任编辑:IT) |