[Hadoop] Hadoop 1.2.1 集群安装一 日期:2016-12-24 17:42:08 点击:197 好评:0

[Hadoop] Hadoop 1.2.1 集群安装一 日期:2016-12-24 17:42:08 点击:197 好评:0

1:安装Linux 2:修改机器名 hostname 显示主机名 [it@localhost bin]$ hostname localhost.sohudo 编辑主机名配置文件 [it@localhost bin]$ vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=localhost.sohudo 用root登录 [it@localhost bin]$ su - 密码...

[Hadoop] Hadoop1.2.1集群安装二 日期:2016-12-24 17:40:46 点击:172 好评:0

[Hadoop] Hadoop1.2.1集群安装二 日期:2016-12-24 17:40:46 点击:172 好评:0

1:安装JDK 下载好jdk-7u45-Linux-x64.gz 或从其它电脑copy过去 [it@feng01 ~]$scp -r ./jdk-7u45-linux-x64.gz it@it.net.cn:/home/it The authenticity of host it.net.cn (10.3.7.214) cant be established. RSA key fingerprint is a8:9d:34:63:fa:c2:47:...

[Hadoop] Hadoop1.2.1集群安装三 日期:2016-12-24 17:36:01 点击:181 好评:0

[Hadoop] Hadoop1.2.1集群安装三 日期:2016-12-24 17:36:01 点击:181 好评:0

配置Hadoop 1:下载hadoop-1.2.1.tar.gz 在/home/it 创建目录 mkdir hadoop 2:解压 [it@it.net.cn hadoop]$ ls hadoop-1.2.1.tar.gz [it@it.net.cn hadoop]$ tar zxf hadoop-1.2.1.tar.gz [it@it.net.cn hadoop]$ ls hadoop-1.2.1 hadoop-1.2.1.tar.gz [it@it....

[Hadoop] hadoop 2.4.1 集群安装一 日期:2016-12-24 17:34:37 点击:92 好评:0

[Hadoop] hadoop 2.4.1 集群安装一 日期:2016-12-24 17:34:37 点击:92 好评:0

配置主机名参考 Hadoop 1.2.1 集群安装一 配置JDK环境参考Hadoop1.2.1集群安装二 配置Hadoop A:下载解压hadoop http://mirrors.cnnic.cn/apache/hadoop/common/hadoop-2.4.1/hadoop-2.4.1.tar.gz 在/home/it 创建目录 mkdir hadoop hadoop-2.4.1.tar.gz下载...

[Hadoop] hadoop 2.4.1 集群安装二 日期:2016-12-24 17:31:34 点击:98 好评:0

[Hadoop] hadoop 2.4.1 集群安装二 日期:2016-12-24 17:31:34 点击:98 好评:0

1:创建目录 [plain]view plaincopy [jifeng@feng01hadoop]$mkdirtmp [jifeng@feng01hadoop]$mkdirname [jifeng@feng01hadoop]$mkdirdata [jifeng@feng01hadoop]$ls datahadoop-1.2.1.tar.gzhadoop-2.4.1.tar.gz hadoop-1.2.1hadoop-2.4.1name hadoop-1.2.1-...

[Hadoop] Hadoop中Namenode单点故障的解决方案及详细介绍 日期:2016-12-24 17:10:55 点击:135 好评:0

[Hadoop] Hadoop中Namenode单点故障的解决方案及详细介绍 日期:2016-12-24 17:10:55 点击:135 好评:0

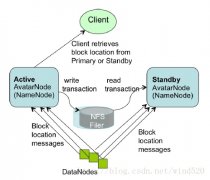

正如大家所知,NameNode在Hadoop系统中存在单点故障问题,这个对于标榜高可用性的Hadoop来说一直是个软肋。本文讨论一下为了解决这个问题而存在的几个solution。 1. Secondary NameNode 原理:Secondary NN会定期的从NN中读取editlog,与自己存储的Image进行...

[Hadoop] 编译hadoop的eclipse插件hadoop-eclipse-plugin-1.2.1.jar 日期:2016-12-24 17:07:58 点击:171 好评:0

[Hadoop] 编译hadoop的eclipse插件hadoop-eclipse-plugin-1.2.1.jar 日期:2016-12-24 17:07:58 点击:171 好评:0

1:下载后Hadoop-1.1.2.tar.gz文件,里面包含源代码,并解压到E:\hadoop\hadoop-1.2.1 2:在eclipse导入工程,目录选择:E:\hadoop\hadoop-1.2.1\src\contrib\eclipse-plugin 3:在项目 MapReduceTools 中新建 lib 目录,将 hadoop-1.2.1 下的 hadoop-core-1...

[Hadoop] 大数据集群环境ambari支持集群管理监控,供应hadoop+hbase+zookeeper 日期:2016-12-17 23:14:16 点击:78 好评:0

[Hadoop] 大数据集群环境ambari支持集群管理监控,供应hadoop+hbase+zookeeper 日期:2016-12-17 23:14:16 点击:78 好评:0

大数据集群环境ambari支持集群管理监控,供应hadoop+hbase+zookeeper Apache Ambari是一种基于Web的工具,支持Apache Hadoop集群的供应、管理和监控。Ambari目前已支持大多数Hadoop组件,包括HDFS、MapReduce、Hive、Pig、 Hbase、Zookeper、Sqoop和Hcatalog...

[服务器集群] CentOS7下LVS+Keepalived实现高性能高可用负载均衡 日期:2016-12-08 17:14:15 点击:87 好评:0

[服务器集群] CentOS7下LVS+Keepalived实现高性能高可用负载均衡 日期:2016-12-08 17:14:15 点击:87 好评:0

一、规划 对外VIP:10.10.10.10对内VIP:192.168.10.10LVS_MASTER:10.10.10.28(eth0)192.168.10.128(eth1)LVS_BACKUP:10.10.10.29(eth0)192.168.10.129(eth1)WEB1:192.168.10.130WEB2:192.168.10.131 二、释义 LVS 是 Linux Virtual Server 的简写,意即 Linux...

[服务器集群] CentOS 6.5 LVS + KeepAlived 搭建 负载均衡 高可用 集群 日期:2016-12-08 17:13:33 点击:173 好评:0

[服务器集群] CentOS 6.5 LVS + KeepAlived 搭建 负载均衡 高可用 集群 日期:2016-12-08 17:13:33 点击:173 好评:0

手把手教程: CentOS 6.5 LVS + KeepAlived 搭建 负载均衡 高可用 集群 为了实现服务的高可用和可扩展,在网上找了几天的资料,现在终于配置完毕,现将心得公布处理,希望对和我一样刚入门的菜鸟能有一些帮助。 一、理论知识(原理) 我们不仅要知其然,而且...

Hadoop原本来自于谷歌一款名为MapReduce的编程模型包。谷歌的MapReduce框架可以把一个...

一、 Apache、Tomcat集群和负载均衡所需资源软件(附下载地址): a) apache_2.0.55-win...

不对的地方,欢迎大家拍砖。 现在有如下三台服务器: 10.57.22.201(做负载均衡配制)(...

一、试验拓扑 二、环境描述 负载均衡器: eth0 192.168.152.139 VIP : 192.168.152.2...